サーバーのメンテナンスやパフォーマンスアップに努めてみたら、Google クローラーの巡回ペースが明らかに上昇してきましたよ。ってお話。

計測対象になってるサイトの情報

全部で3000ページある私の管理するWebサイト。

検索対象ページは2000。有用なコンテンツが掲載されたページは1000。

Google Botは主に、この1000ページをクローリングしに来る。

サイト更新は平均週4回

さくらのVPSで運営。なので色々弄れる。

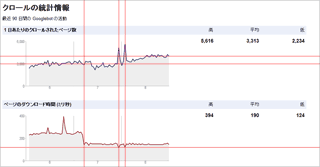

Google Botの巡回頻度

今年の4~7月頃は2200~2700ページ/day でクローリング。

現在は3700~4200ページ/day

ガッツリメンテ&チューンした日はピーク時は5600ページ/day

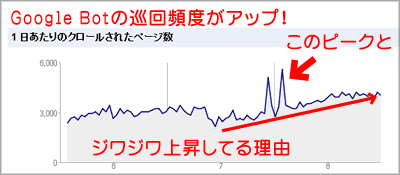

サーバーのレスポンスとGoogleクローラーの巡回頻度

Google Botのクローリング数と、HTMLファイルのダウンロード時間(サーバーのレスポンス時間)に、密接な関係が出てきた。

PHPで表示している箇所の最適化を行い、htmlファイルのダウンロード時間を250msから160msに短縮したら、Botの巡回頻度がジワジワ上がってきた。

125ms前後まで短縮したら、巡回頻度が爆裂し、1日5600ページとかクローリングがあった。

Googleは更新頻度やサーバーのレスポンスにある程度の閾値を設けていて、それをクリアしたサイトにはかなり頻繁にクローラーを巡回させるようです?

現在の私の技術とWebページの構成では、サーバーレスポンスを常に160ms前後に保つ事は可能だけど125ms以下にするのは現実的じゃないのが残念な所。

(phpの数を半分にするか、アクセス解析を止めるか、MySQLを12時間毎に最適化すれば可能だけど面倒臭い(^_^;)

検索順位への影響について

Googleクローラーの巡回頻度は明らかに上昇したけれど、検索順位に上昇が見られたか?

と云うとそんな気配は全く無し(^_^;

とりあえず、新着ページはPing打たなくても瞬時に検索結果に反映されるようにはなりましたが、この程度では何も変わらんです。

2009年ごろに「Googleは近い将来Webページの表示速度の速さも検索結果に(わずかだが)影響を与えるようにする」ってなコメントを出したんですが(参考リンク)、これは画像やJavascript含めたページ全体のパフォーマンスに関するお話でしたよね?

少なくともページ全体で2秒以下で表示させる事が必要。

サーバー改善して0.1秒短縮しても全く意味無いですw

もう少しまとまった時間が出来たらphpアクセラレーターの導入を検討したい。